The overview of this paper

RNN 즉, recurrent neural network는 오랜 시간 동안 사용되어온 신경망이다. 하지만, 시간의 흐름에 따라 처리해야 하는 데이터의 양이 많아짐과 task의 복잡도가 증가함에 따라서 RNN으로부터 장기의존성의 문제가 존재함을 알게 되었다. $($장기의존성에 대해 잘 모르신다면 여기를 참고해주세요!!$)$ 이를 해결하기 위해 gating unit을 가지고 있는 새로운 RNN 모델들인 LSTM과 GRU 등이 등장하게 되었다. 이 둘은 상당히 좋은 성능을 보여주지만, 둘 중 어떤 것이 더 우월한 모델인지에 대해서는 의견이 분분했다. 그래서 이 논문은 이러한 논란을 잠재우고자 좀 더 세밀하게 이 두 모델의 성능을 비교해보고자 하였다.

Table of Contents

1. Introduction

2. Background: RNN

3. Gated RNN

3-1. LSTM Unit

3-2. GRU

3-3. Discussion

4. Results and Analysis

1. Introduction

논문이 작성되었을 당시에 딥러닝 task들에서 좋은 성능을 거둔 모델들을 살펴보면 대부분이 RNN으로부터 파생된 모델들이었다. 그 중에서도 이 논문에서는 LSTM과 GRU에 대해서 깊은 관심을 가졌다. GRU는 LSTM이 좋은 성능을 보여주고 있는 분야인 장기의존성을 가지고 있는 sequence 기반의 task에서 잘 작동하도록 설계되었지만, 최근에 공개된 모델로 아직 machine translation 분야에서 정도 밖에 사용되지 않았었다.

그래서 이들의 성능을 제대로 비교해보고자, LSTM, GRU, tanh$($전통적인 RNN unit$)$ 이렇게 세 개의 모델에 polyphonic music dataset을 사용하여 성능을 비교하였다.

실험의 결과부터 살~짝 스포를 하자면! gating unit 즉, LSTM과 GRU가 tanh 모델보다 더 좋은 성능을 보여줬고, 제한된 parameter의 수에서는 GRU가 LSTM을 능가하는 성능을 보여줬다고 한다.

2. Background: RNN

RNN은 다양한 길이의 sequence 입력을 다룰 수 있는 기존의 feedforward neural network의 연장선인 셈이다. RNN은 다양한 길이의 sequence 입력을 이전의 activation에 의존하는 각 시점의 activation을 가지는 recurrent hidden state를 사용하여 다룬다.

이를 좀 더 공식적으로 표현하면, sequence $x = (x_1, x_2, ..., x_r)$이 주어지면, RNN은 recurrent hidden state $h_t$를 다음과 같이 업데이트 한다.

$\textbf{h}_t=\left\{\begin{matrix}

0, t=0 \\\phi (\textbf{h}_{t-1}, x_t), otherwise

\end{matrix}\right.$

여기서 $\phi$는 비선형 함수로 예를 들어 affine 변형이 있는 logistic sigmoid의 결합인 셈이다. 이를 통해, RNN은 또 다시 다양한 길이를 가지는 출력값 $\textbf{y}=(y_1, y_2,...,y_r)$이 되게 될 것이다.

전통적으로, 위의 recurrent hidden state의 업데이트는 다음과 같이 시행된다.

$\textbf{h}=g(W\textbf{x}_t+U\textbf{h}_{t-1})$

여기서 $g$는 부드럽게 만들어주는 함수로 logistic sigmoid 또는 hyperbolic tangent 함수와 같은 것들이다.

generative RNN은 현재의 state $\textbf{h}_t$가 주어지면, 시퀀스의 다음 요소에 대한 확률 분포를 출력한다. 그리고, 이러한 generative model은 시퀀스의 마지막을 표현하는 특별한 기호를 사용하여 다양한 길이의 시퀀스의 확률 분포를 파악할 수 있다. 시퀀스 확률 분포는 다음과 같이 분해될 수 있다.

$p(x_1,...,x_r)=p(x_1)p(x_2|x_1)p(x_3|x_1, x_2) \cdots p(x_r|x_1,...,x_{r-1})$

여기서 마지막 요소는 특별한 시퀀스의 마지막을 가리키는 값이다. 이러한 각각의 조건부 확률 분포를 다음과 같이 모델링하였다.

$p(x_t|x_1,...,x_{t-1})=g(h_t)$

여기서 $h_t$는 맨 처음 수식으로부터 얻은 값이다. 이러한 generative RNN이 이 논문의 실험체 중 하나이다.

하지만, 안타깝게도 RNN은 장기의존성을 해결하지 못한다는 크나큰 문제점을 가지고 있다. 이 장기의존성으로 인하여 기울기가 사라지거나, 반대로 폭발하게 되는 gradient vanishing 문제와 gradient explosion 문제가 발생하기 때문에 이는 성능에 크나큰 악영향을 미칠 수 있다. 이를 해결하기 위한 해결책으로 두 가지의 방법이 소개되었다.

- clipped gradient 사용: 말 그대로 기울기를 clip해두고 사용하는 방법

- 더욱 복잡한 활성화 함수 사용: affine으로 구성된 gate unit을 사용하는 것인데, 이 방법의 대표적인 예가 LSTM과 GRU인 것이다. 이 둘은 장기의존성 문제를 완화함으로써 RNN의 대안책이 되었다.

3. Gated RNN

3-1. LSTM Unit

기존의 입력 시그널의 가중치 합을 계산하고, 비선형 함수를 적용하는 심플한 recurrent unit과 달리, LSTM의 각 $j$-번째 unit은 time $t$에서 메모리 $c_{t}^{j}$를 유지한다. 출력값 $h_{t}^{j}$, 또는 LSTM unit의 activation은 다음과 같다.

$h_{t}^{j}=o_{t}^{j}tanh(c_{t}^{j})$

여기서 $o_{t}^{j}$는 output gate로, memory content가 얼마나 노출될 지를 조절한다. 이 output gate는 다음과 같이 계산된다.

$o_{t}^{j}=\sigma(W_{o}\textbf{x}_{t}+U_{o}\textbf{H}_{t-1}+V_{o}\textbf{c}_{t})^{j}$

여기서 $\sigma$는 logistic sigmoid 함수이고, $V_{o}$는 대각행렬이다.

메모리 셀 $c_{t}^{j}$는 현재의 메모리를 부분적으로 잊고, 새로운 메모리 콘텐츠 $\tilde{c}_{t}^{j}$가 추가되면서 업데이트 된다.

$c_{t}^{j}=f_{t}^{j}c_{t-1}^{j}+i_{t}^{j}\tilde{c}_{t}^{j}$

여기서 새로운 메모리 콘텐츠는 다음과 같다.

$\tilde{c}_{t}^{j}=tanh(W_{c}\textbf{x}_{t}+U_{c}\textbf{H}_{t-1})^{j}$

존재하는 메모리를 얼마나 잊을 지는 forget gate $f_{t}^{j}$에 의해 조정되고, 새로운 메모리가 얼마나 추가될 지는 input gate $i_{t}^{j}$에 의해 결정된다. 다음은 forget gate와 input gate를 구하는 수식이다.

$f_{t}^{j} = \sigma (W_{f} \textbf{x}_{t} + U_{f} \textbf{h}_{t-1} + V_{i} \textbf{c}_{t-1})^{j}$

$i_{t}^{j} = \sigma (W_{i} \textbf{x}_{t} + U_{i} \textbf{h}_{t-1} + V_{i} \textbf{c}_{t-1})^{j}$

여기서 $V_f$와 $V_i$는 대각 행렬이다.

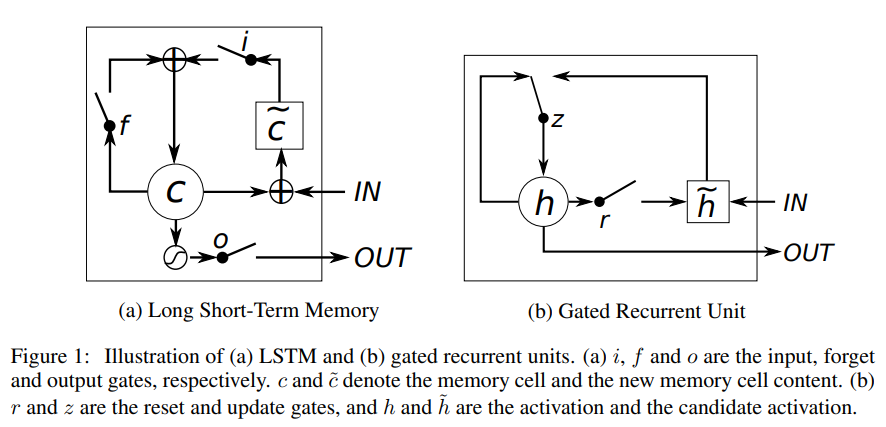

기존의 revurrent unit은 각 time-step에 새로운 데이터를 덮어쓰는 방식으로 진행되었는데, LSTM은 보존할 메모리는 보존하고, 잊어버릴 메모리는 잊어버림으로써 기억할 메모리를 조정 가능하다. 따라서 장기의존성 문제를 해결할 수 있었다. 이 LSTM unit의 대략적인 구조는 위의 그림 1의 $($a$)$를 참고하길 바란다.

3-2. GRU

GRU는 LSTM과 유사하게 gate unit이 존재하지만, 따로 memory cell은 가지고 있지 않다.

시점 $t$에서 GRU의 activation $h_{t}^{j}$는 이전 activation $h_{t-1}^{j}$와 후보자 activation $\tilde{h}_{t}^{j}$의 선형 보간이다.

$h_{t}^{j}=(1-z_{t}^{j})h_{t-1}^{j} + z_{t}^{j}\tilde{h}_{t}^{j}$

여기서 update gate $z_{t}^{j}$는 이 activation을 얼마나 업데이트할 지 결정한다. update gate는 다음과 같이 계산된다.

$z_{t}^{j}=\sigma (W_{z}\textbf{x}_{t} + U_{z}\textbf{H}_{t-1})^{j}$

기존의 state와 새롭게 계산된 state간의 선형 결합을 계산하는 절차는 LSTM unit과 유사하다. 하지만, GRU는 LSTM과 달리 전체 state를 각 시점에 동시에 노출시키게 된다.

후보자 activation $\tilde{h}_{t}^{j}$는 기존의 recurrent unit과 유사하게 계산된다.

$\tilde{h}_{t}^{j}=tanh(W\textbf{x}_{t} + U (\textbf{r}_{t} \odot \textbf{h}_{t-1}))^{j}$

여기서 $\textbf{r}_t$는 reset gate이고 $\odot$은 element-wise 곱이다. 만약 $\textbf{r}_{t}^{j}$가 0에 가까워지면더욱 확실하게 이전의 state를 까먹게 된다.

reset gate $r_{t}^{j}$는 update gate와 유사하게 계산된다.

$r_{t}^{j}=\sigma (W_{r}\textbf{x}_{t} + U_{r}\textbf{h}_{t-1})^{j}$

그림 1의 $($b$)$를 보면 GRU의 대략적인 구조를 알 수 있다.

3-3. Discussion

LSTM과 GRU가 공유하는 가장 주요한 특징은 전통적인 RNN에서는 부족한 추가적인 요소가 존재한다는 것이다. 이 추가적인 요소를 통해 content는 유지하고, 그 위에 새로운 content를 쌓을 수 있게 된다.

이러한 추가적인 요소가 존재함으로써 다음의 두 가지 장점을 얻을 수 있다.

- 각 unit이 입력 stream의 특징을 오랫동안 기억할 수 있다. 이는 LSTM의 forget gate와 GRU의 upadte gate로 결정남.

- multiple step을 우회하는 숏컷 생성. 이를 통해 vanishing 없이 error가 손쉽게 역전파 되도록 허용함.

이 LSTM과 GRU는 차이점을 가지고 있는데, GRU에서는 사용하지 않는 LSTM의 한 가지 특징은 memory content의 노출을 조절할 수 있다는 것이다. LSTM은 output gate에 의해 memory content의 양과 unit이 조절된다. 이와 반대로 GRU는 어떠한 조절 없이 모든 content를 드러낸다.

또 다른 차이점은 input gate에 상응하는 reset gate의 위치 차이이다. LSTM은 input gate에서 이전 시점으로부터 정보의 흐름을 생각하지 않고, forget gate에서 새로운 memory cell이 독립적으로 추가된다. 이와는 반대로, GRU는 이전의 activatiopn으로부터 새로운 activation을 계산할 때 조절한다.

이러한 두 모델의 차이점 때문에, 두 모델의 성능을 비교하는 데에는 많은 어려움이 있었다. 이러한 점이 이 논문의 저자들을 자극하여 좀 더 세밀한 LSTM과 GRU의 성능 비교를 하도록 이끌어냈다.

4. Results and Analysis

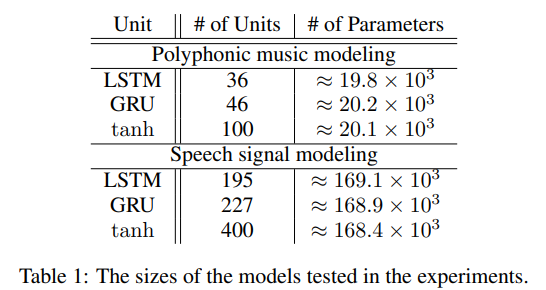

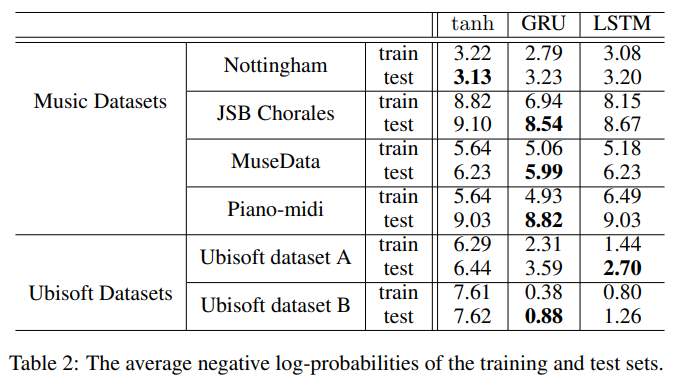

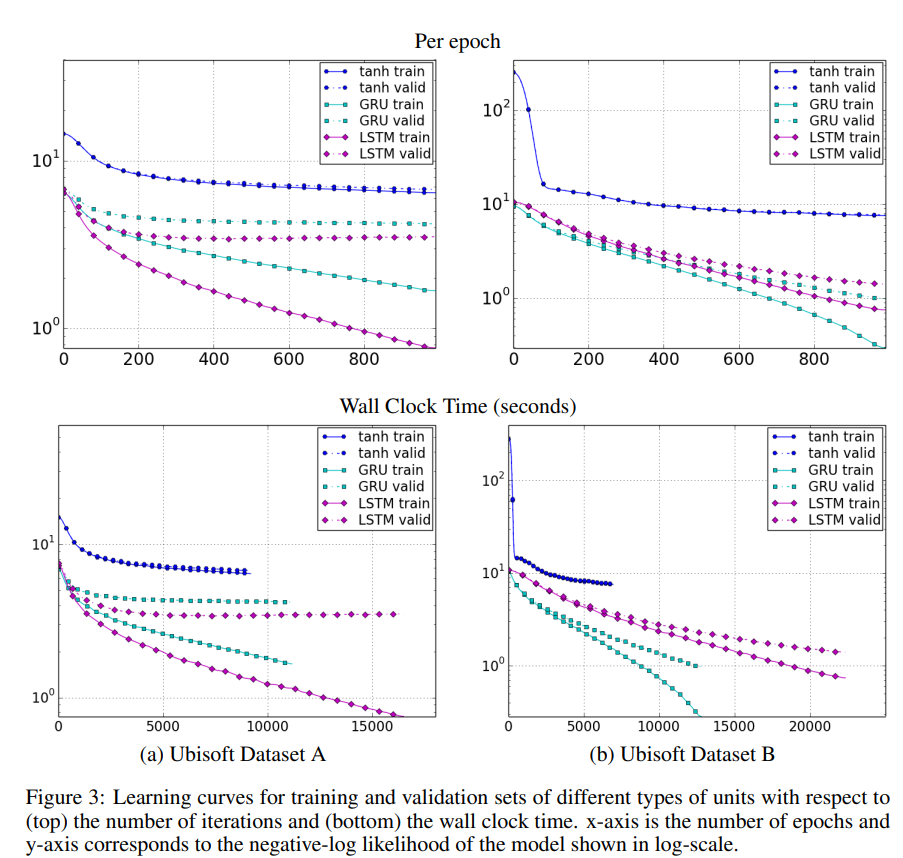

논문의 experiment에서는 총 3개의 모델을 비교한다. 바로 LSTM, GRU, tanh unit이다. 논문의 가장 주된 목적은 세 개의 모델을 공정하게 비교하는 것이기 때문에, 모두 같은 수의 parameter을 가지도록 구성하였고, 모델은 최대한 작게 만들어서 오버피팅을 방지하였다. 그 결과 모델의 세부사항은 표 1과 같고, 그에 대한 결과는 표 2와 같다.

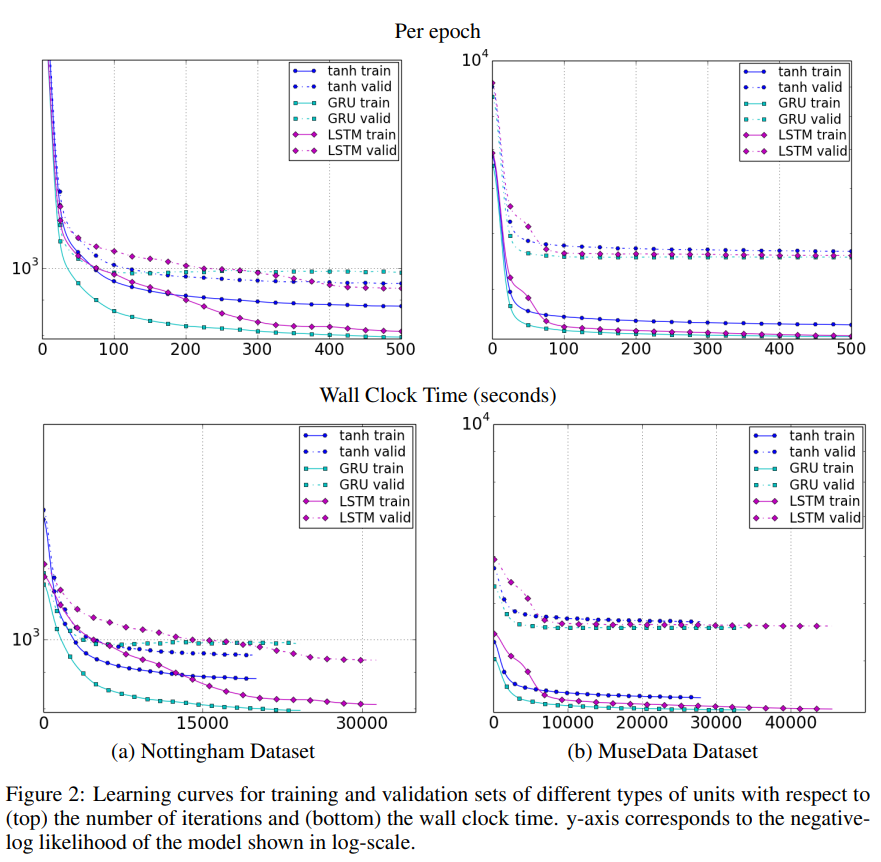

위 표 2를 보면 알 수 있듯이, 기존의 recurrent unit인 tanh unit보다 gating unit인 LSTM과 GRU가 대부분의 데이터셋에서 더 나은 성능을 보여준다는 것을 알 수 있다. 그리고 GRU또한 대부분의 데이터셋에서 LSTM보다 더 나은 성능을 보여주는 것을 알 수 있다. 그렇다고 GRU가 LSTM보다 더 우수하다고 단정할 수는 없다. 특정 데이터셋에서는 GRU가 LSTM보다 더 빠른 learning curve 수렴을 보여주긴 한다.

하지만, 또 다른 데이터셋에서는 오히려 LSTM이 GRU보다 빠른 수렴을 보여준다.

따라서, LSTM과 GRU의 성능은 데이터셋과 그에 상응하는 task에 크게 좌지우지된다는 사실을 알 수 있다.

출처

https://arxiv.org/abs/1412.3555

Empirical Evaluation of Gated Recurrent Neural Networks on Sequence Modeling

In this paper we compare different types of recurrent units in recurrent neural networks (RNNs). Especially, we focus on more sophisticated units that implement a gating mechanism, such as a long short-term memory (LSTM) unit and a recently proposed gated

arxiv.org

'Paper Reading 📜 > Deep Learning' 카테고리의 다른 글

| Zero-shot, One-shot, Few-shot Learning이 무엇일까? (3) | 2023.03.12 |

|---|---|

| Prompt Engineering이 무엇일까? (0) | 2023.03.01 |

| 알기 쉽게 LSTM networks 이해하기 (2) | 2023.01.27 |

| Distilling the Knowledge in a Neural Network 논문 리뷰 (0) | 2023.01.26 |

| CNN network의 역사 (0) | 2022.12.14 |