저번 포스트에 이어서 Chain-of-Thought$($CoT$)$에 관한 논문을 읽고 리뷰해 보았다. $($이전 포스트 참고!!$)$ LM에게 인간처럼 step-by-step으로 reasoning을 할 수 있도록 만들어준 개념으로 상당히 신기하였다. 이를 통해 resoning task에서 뛰어난 성능을 보여주긴 했지만, 아직 각각의 task에 대해서 사람이 특별하게 제작한 example을 추가적으로 주어야 한다는 점에서 아쉬움을 갖고 있었다. 한 마디로, 아직 Few-shot-CoT에 불과했다는 점이다. 이러한 Few-shot-CoT를 Zero-shot-CoT로 탈바꿈시킨 논문이 바로 'Large Language Models are Zero-Shot Reasoners'인 것이다!! 어떻게 CoT를 zero-shot learning으로 사용했을 지 궁금하여 이 논문에 대해 읽어보았고, 논문에 대한 리뷰를 지금부터 시작하겠다!!

'Large Language Models are Zero-Shot Reasoners' 논문 링크: https://arxiv.org/abs/2205.11916

The overview of this paper

사전 학습된 Large Language Model$($LLM$)$은 NLP 분야에서 많이 사용되고 있고, task-specific한 task에 대해 few-shot learner로써 훌륭한 퍼포먼스를 보여주고 있다. 근래에 새롭게 제시된 Chain-of-Thought$($CoT$)$는 복잡한 reasoning task를 step-by-step 방식으로 접근하여 여러 task에서 SOTA를 달성하였다. 이러한 CoT는 few-shot learning에 특화되어 있는 모습을 보여줬지만, Zero-shot-CoT 또한, 여러 task에서 기존의 Zero-shot model들의 성능을 압도하는 모습을 보여줬다! 심지어 어려운 방법을 사용한 것도 아니라, 그저 'Let's think step-by-step$($순차적으로 생각해보자$)$'라는 문장을 예측 전에 주었을 뿐이다. 이를 통해 Few-shot에 근접하는 성능을 보여주었고, 많은 기존의 Zero-shot performance를 넘어섰다. 논문에서는 이러한 발견을 그저 강력한 Zero-shot baseline을 발견한 것에 그치지 말고, dataset을 fine-tuning하거나 few-shot exampler을 만들기 전에, LLM에 내포되어 있는 거대한 zero-shot 지식을 자세하게 탐사하고 분석하는 것의 중요성을 일깨워주길 바란다고 한다.

Table of Contents

1. Introduction

2. Background

3. Zero-Shot Chain-of-Thought

3-1. Two-stage prompting

4. Experiment

4-1. Results

1. Introduction

LM의 크기를 키우는 것은 현재의 NLP 분야에서 매우 중요한 요소이다. LLM에 대한 성공은 보통 few-shot 또는 zero-shot learning을 통해 이루어진다. LM은 다양한 task에 대해 모델을 적은 예시에 적용시키거나$($few-shot$)$, task에 대한 설명을 줌$($zero-shot$)$으로써 다양한 task를 해결해나간다. LM을 conditioning하는 과정을 "prompting"이라 부르고, prompts를 수동 혹은 자동으로 디자인할 지는 NLP에서 매우 핫한 주제 중 하나이다. 🔥

Chain-of-Thought$($CoT$)$는 LLM에게 기존의 질문과 그에 대한 정답 예시를 주기 보다는, step-by-step reasoning 예시를 주는 방법이다. 이러한 CoT는 모델에게 reasoning path를 생성할 수 있게 해주고, 그에 따라서 복잡한 문제를 여러 개의 쉬운 step으로 분해할 수 있게 해준다. CoT를 통해 scaling size에 따른 성능 상승 효과도 가져올 수 있었다. 따라서, 엄청난 크기를 자랑하는 PaLM과 CoT를 함께 사용하였을 때, 기존의 few-shot performance를 훨씬 웃도는 성능을 보여줬다.

CoT prompting의 성공에, 많은 task-specific prompting work들은 LLM의 few-shot learning 능력만 사용하였다. 그래서, 이 논문에서는 간단한 prompt인 'Let's think step by step'을 zero-shot reasoner에 추가하여 few-shot performance에 준하는 성능을 얻고자 하였다. 이렇게 간단함에도 불구하고, Zero-shot-CoT는 기존의 zero-shot method들이 실패했던 task에 대해 그럴듯한 reasoning path를 만들어 내고, 정확한 답을 도출해내었다! 그리고 중요한 것은, Zero-shot-CoT는 이전의 task-specific한 prompt engineering과는 달리, 다용도적이자 task-agnostic$($지식 없이도 수행 가능한$)$ 하다! 이러한 Zero-shot-CoT를 3개의 수리적 task와 3개의 reasoning task에 대해 적용해보았다.

확실히, 자세하게 작성된 step-by-step example을 사용한 Few-shot-CoT에 비해서는 성능이 떨어졌다. 하지만, 이전의 zero-shot-baseline들보다 훨씬 뛰어난 성능을 보여주었다! 그리고 또한, scaling curve 측면에서 Few-shot보다 Zero-shot이 더 나은 모습을 보여줬다!

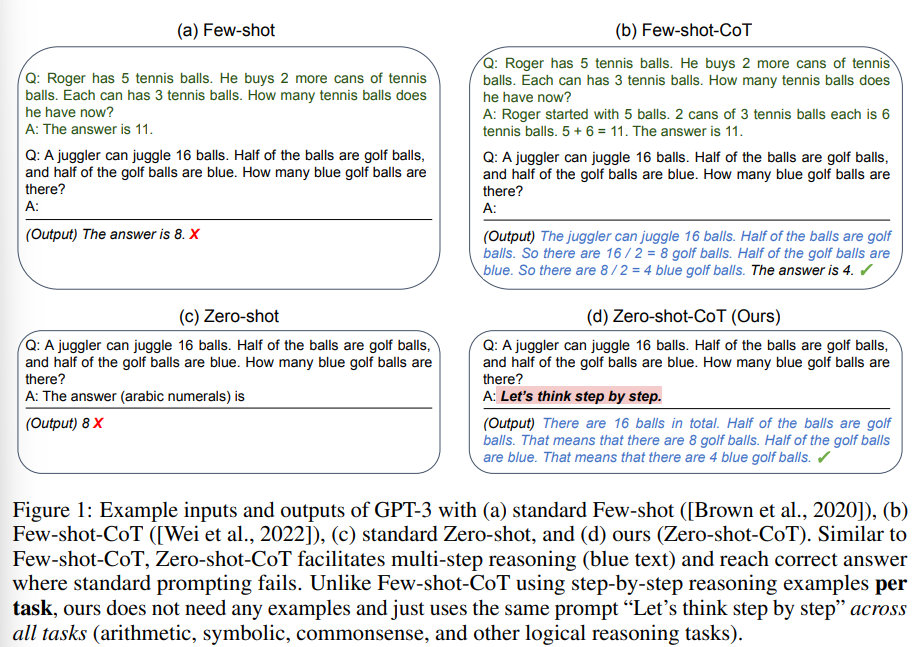

다음의 그림 1은 기존의 Few-shot, Zero-shot과 Few-shot-CoT, Zero-shot-CoT의 결과를 보여주고 있다.

2. Background

이 논문을 읽기 위해 필요한 두 가지 개념을 간략하게 짚고 넘어가보자: LLM의 출현과 prompting & CoT prompting

Large language models and prompting

language model$($LM$)$은 text에 대한 확률 분포를 조사하는 모델이다. 최근에, 모델 크기의 증가와 데이터의 증가로 인해, 놀라울 정도로 많은 분야에 적용시킬 수 있는, 사전 학습된 LLM를 만드는 것이 가능해졌다. 게다가, 기존의 "pre-traine & fine-tune" 방식에서, 모델의 파라미터 수가 증가함에 따라, text 또는 template을 사용하여 원하는 task의 정답을 출력하는 prompt 방식이 출현함에 따라, "pre-train & prompt"의 시대가 도래하기 시작했다. 조금의 task example을 사용하는 prompt를 few-shot prompt, template만을 사용하는 prompt를 zero-shot prompt로 부르도록 하겠다.

Chain of thought prompting

수리적 또는 논리적 reasoning 벤치마크는 LLM의 scaling law를 벗어나는 매우 어려운 task였다. CoT prompting은 few-shot example을 step-by-step으로 변형함으로써 간단한 해결책을 제안하였다. 그리고 실제로도 뛰어난 성능을 보여줬다!

기존의 CoT는 앞으로 Few-shot-CoT라고 부를 것이다. CoT에 대한 더욱 자세한 설명은 다음의 포스트를 참고하길 바란다.

3. Zero-shot Chain of Thought

논문에서는 CoT reasoning을 위해 zero-shot template 기반의 prompting을 사용하는, Zero-shot-CoT를 제안하였다. 이는 기존의 CoT와 달리, step-by-step few-shot example을 제공할 필요가 없고, 이전의 template prompting과 달리 하나의 template을 사용하여 multi-hop reasoning을 끌어내었고, task-agnostic 하였다. 핵심 아이디어는 그림 1에서 언급했던 것처럼 간단한데, step-by-step reasoning을 끌어내기 위해, Let's think step by step을 추가하거나, 이와 비슷한 문장을 추가하는 것이다!

3.1 Two-stage prompting

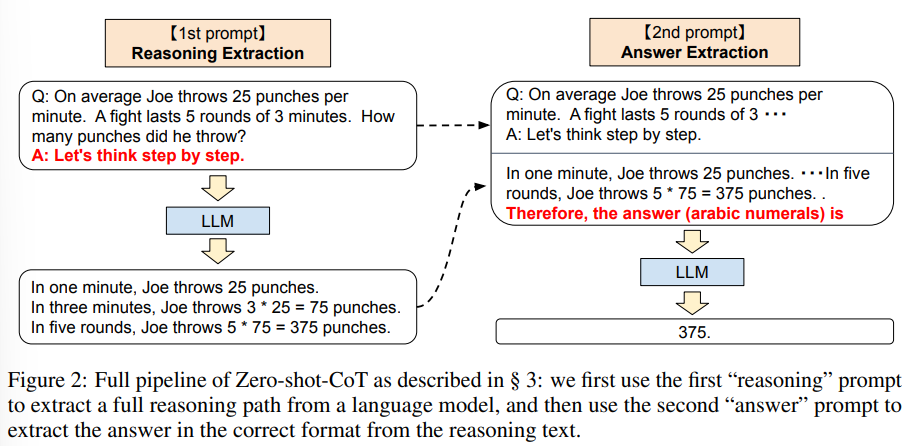

Zero-shot-CoT는 개념적으로 간단한 반면에, 다음의 그림 2처럼 reasoning과 answering을 위해 두 번의 prompting을 사용한다. 반면에, zero-shot-baseline은 $($그림 1의 왼쪽 밑 부분 참고$)$ 알맞은 형식의 답을 도출하기 위해 앞에서 "The answer is" 라는 prompting을 이미 사용하였다. 기존 방법이나 CoT의 Few-shot prompting은 answer-extraction prompting을 피하기 위해 few-shot example을 특정 형식으로 디자인해야 한다. $($그림 1의 오른쪽 위와 왼쪽 위를 참고$)$. 요약하면, Few-shot-CoT는 각각의 task에 대한 자세한 answer 형식과 함께 사람이 조심스레 angineering한 적은 양의 prompt example을 필요로 하지만, Zero-shot-CoT는 적은 양의 engineering을 필요로 하는 반면에, prompting을 두 번 필요로 한다.

첫 번째 prompt: 추리 추출

이 단계에서는, 입력 질문인 $\textbf{x}$를 간단한 템플릿 "Q: [X], A: [T]"를 사용하여, prompt $\textbf{x}^{'}$ 조정한다. 여기서, [X]는 $\textbf{x}$에 대한 입력 슬롯이고, [T]는 hand-crafted trigger 문장에 대한 슬롯 $\textbf{t}$이다. $\textbf{t}$는 질문 $\textbf{x}$에 대답하기 위한 chain of thought를 도출해낼 수 있다. 예를 들어, "Let's think step by step"을 trigger sentence로 사용하면, prompt $\textbf{x}^{'}$는 "Q: [X], A: Let's think step by step."이 될 것이다. 그 다음에, promped text $\textbf{x}^{'}$는 LM에 주어지게 되고, 후속의 문장 $\textbf{z}$를 생성한다.

두 번째 prompt: 대답 추출

두 번째 단계에서는, 생성된 문장인 $\textbf{z}$와 prompted sentence $\textbf{x}^{'}$을 사용하여, LM로부터 최종 대답을 추출해낸다. 이 3개의 요소를 "[X'] [Z] [A]"로 합쳤다. 여기서, [X']는 첫 번째 prompt의 $\textbf{x}^{'}$이고, [Z]는 첫 번째 단계에서 생성된 문장 $\textbf{z}$이고, [A]는 대답을 추출하기 위한 trigger sentence이다. 이 단계에서의 prompt는 self-augmented 방식으로 진행되는데, 왜냐하면 prompt가 똑같은 LM로부터 생성된 문장 $\textbf{z}$를 포함하기 때문이다. 실험에서는, 대답 형식에 따라서 살짝씩 다른 trigger을 사용하였다.

4. Experiment

실험에 관해서는 자세하게 다루지는 않고, 각각의 dataset에 대해 모델이 어느 정도 성능을 보여줬고, 그 성능에 대한 분석과 독특했던 점에 대해서 짚고 넘어가도록 하겠다.

Datasets

실험에 사용된 데이터셋은 총 6가지인데, 3가지는 기본적인 수리력을 평가하는 데이터셋이고, 다른 3가지는 좀 더 최근에 만들어진 데이터셋으로 한 가지는 간단한 수리력을 평가하고, 다른 두 가지는 조금 어려운, 여러 resoning step을 요구하는 문 데이터셋이다.

Models & Baselines

모델은 17개의 모델을 사용하였는데, 자세한 내용은 논문을 참고하길 바란다.

Answer cleansing

모델이 answer extraction을 통해 text를 출력하면, 그 중에서 가장 첫 번째로 만족하는 대답 형식을 추출한다. 예를 들어, prompting 출력이 "아마도 375나 376"일 때, 첫 번째 숫자인 "375"를 모델의 예측으로 설정한다.

4-1. Results

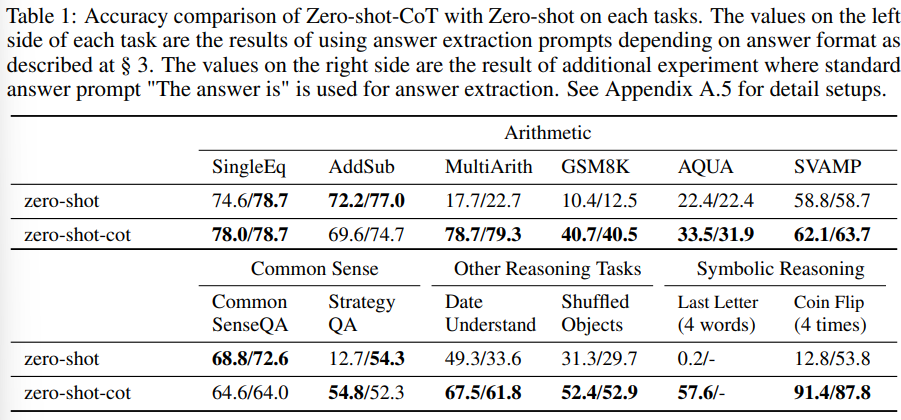

Zero-shot-CoT vs. Zero-shot

다음의 표 1은 Zero-shot-CoT의 정확도와 기존의 zero-shot prompting의 정확도를 각각의 데이터셋에 대해 요약한 것이다. Zero-shot-CoT는 6개 중 4개의 데이터셋에서 상당히 압도하는 성능을 보여줬다. 예를 들어, MultiArith와 GSM8K 데이터셋에서 엄청나게 좋은 성능을 보여줬다. 그리고 SingleEq와 AddSub에서는 조금 떨어지는 성능을 보여줬는데 이는 multi-step reasoning을 요구하지 않는 task였기 때문이다.

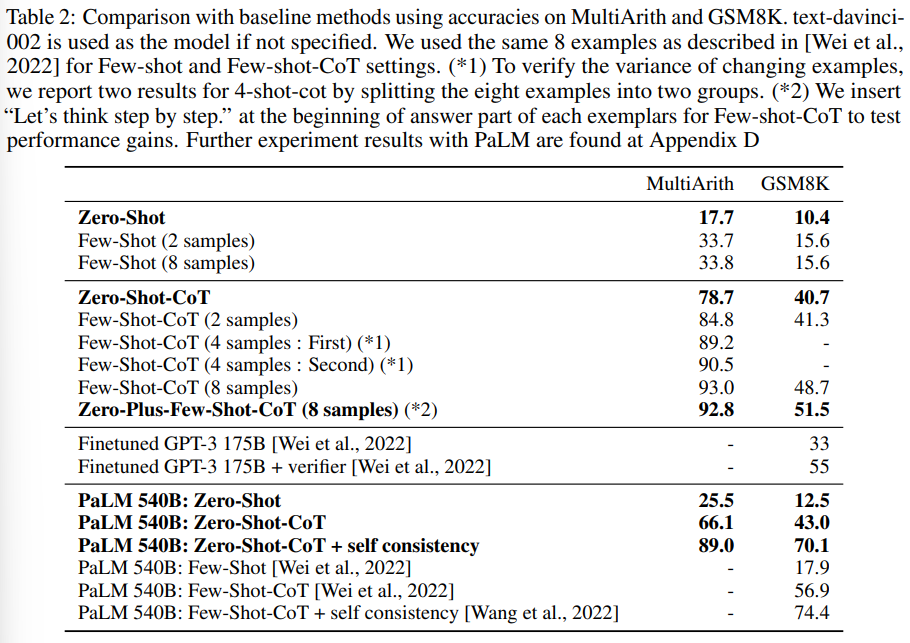

Comparison with other baselines

다음의 표 2는 두 개의 수리 reasoning 벤치마크에 대해 Zero-shot-CoT와 baseline의 성능 비교를 보여준다. 그 결과, 기존의 prompting과 Zero-shot-CoT 간에 multi-step reasoning을 요구하지 않는 task에 대해서 엄청난 성능 차이가 있다는 것을 알 수 있다. 하지만, Zero-shot-CoT도 Few-shot-CoT에 비해서는 떨어지는 성능을 보여준다.

Does model size matter for zero-shot reasoning?

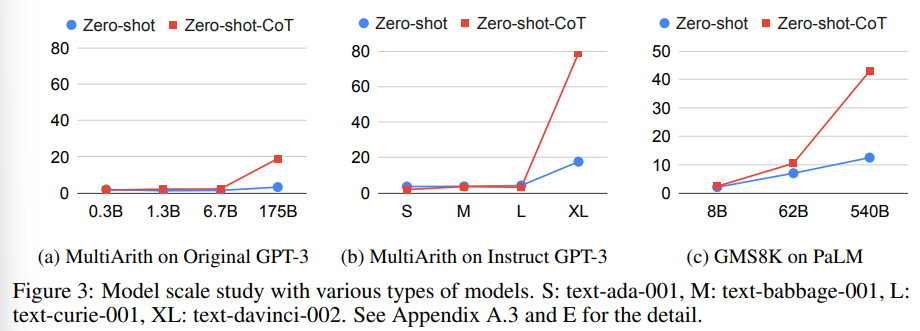

다음의 그림 3은 다양한 LM의 MultiArith와 GSM8K에 대한 성능을 비교하고 있다. CoT가 없을 때에는, 성능에 변화가 없거나, 아주 느리게 상승하고 있는 것을 알 수 있다. 한 마디로, 커브가 평평하다. 반대로, CoT와 함께할 때는, 모델의 크기가 커짐에 따라, 성능이 급격하게 상승하는 것을 알 수 있다.

Error Analysis

Zero-shot-CoT의 특성을 더욱 잘 파악하기 위해, Zero-shot-CoT와 Instruct GPT-3로부터 생성되는 example을 랜덤하게 선택하여 조사하였다. 이러한 과정을 통해 다음과 같은 결과를 얻을 수 있었다.

- commonsense reasoning: Zero-shot-CoT는 정답을 틀리기는 했지만, 유연하고 합리적인 chain of thought를 보여줬음. 답을 하나로 좁히기 어려울 때는 여러 개의 답을 내놓기도 함.

- arithmetic reasoning: Zero-shot과 Few-shot이 전혀 다른 error 패턴을 보임. Zero-shot은 답을 갖게된 후에도 불필요한 step을 가졌고, 어떨 때는 reasoning이 아닌 질문을 paraphrasing 하기도 하였음. Few-shot은 3겹의 계산에는 chain of thought를 생성할 수 없었음. ex) (3 + 2) * 4

실험에는 더 많은 내용들이 존재하지만, 여기서 마쳐보도록 하겠다. 더욱 자세한 내용을 알고 싶다면 논문을 참고하길 바란다.

출처

https://arxiv.org/abs/2205.11916

Large Language Models are Zero-Shot Reasoners

Pretrained large language models (LLMs) are widely used in many sub-fields of natural language processing (NLP) and generally known as excellent few-shot learners with task-specific exemplars. Notably, chain of thought (CoT) prompting, a recent technique f

arxiv.org