LM의 context window, 길어야 할까? 짧아야 할까? 📏🤨

Newly spotlighted elements of LM ✨

LM은 시시각각 변화해가고 있다. 며칠 전에 새롭게 발표된 모델이 오늘에서는 그 면모가 낱낱이 파악되어 부족한 점들이나 단점들이 지적받고 있는 요즘이다. 😥 그만큼 LM은 그것이 파라미터든 데이터든 다방면으로 빠르게 변화해나가고 있는데, 이번 포스팅에서 다뤄보고자 하는 내용은 오랜 시간 동안 별로 건드려지지 않다가 최근에 여러 연구(Chen et al., 2023, Ding et al., 2023, Liu et al., 2023)를 통해 다시 각광받고 있는 내용인 LM의 context window에 대해서 얘기해보고자 한다! 😊

What is the 'context window'? 🤔

시작하기에 앞서서 이번 포스팅에서 중요하게 다뤄볼 내용인 'context window', 과연 무엇인걸까? 직역을 해보면 '문맥 창'이라는 뭔가 아리송한 의미를 얻을 수 있을 것이다. 😊 이것이 사람의 관점에서 바라보았기에 이상했던 것이지 모델의 관점에서 본다면 지극히 정상적인 표현이라고 할 수 있다! 하지만, 아직 우리는 사람이기에 아리송하기만 할 텐데 차근차근 모델의 관점에서 context window를 알아가 보도록 하자! 🚩

context window를 이해하기 위해서는 LM이 text를 어떤 방식으로 이해하는지를 우선 이해해야 할 필요가 있다. 이 설명을 위한 예시 문장으로 다음의 문장을 예시로 사용하도록 하겠다.

'나는 가방을 메고 있다.'

먼저 사람의 입장에서 생각해보면 뭐 사실 이해하고 분석하고 할 것도 없이 그냥 '아 가방을 메고 있구나~'라고 바로 결론이 나올 수 있을 것이다. 😄 하지만 LM은 그러할 수 없으니 이 문장을 찬찬히 보고 하나하나 뜯어봐야 한다. 이때 이 문장의 요소를 하나하나 뜯어보기 위해 필요한 것이 바로 모델이 사용하는 단어라고 부를 수 있는 'Token(토큰)'이라는 것이다! 사실 이 token은 tokenizer의 종류에 따라서 토큰화되는 방식이 상이한데 간단하게 word-level의 tokenizer(실제로 사용되는 tokenizer는 훨씬 더 복잡한 기준을 가지고 토큰화를 진행합니다)를 사용한다고 했을 때 위의 예시 문장은 다음과 같이 토큰화가 될 수 있다.

['나는', '가방을', '메고', '있다']

이렇게 보니 좀 더 직관적으로 모델이 어떻게 text를 바라보는지 이해할 수 있지 않는가? 😊 물론 이렇게 토큰화된 token을 가지고 자신만의 vocabulary에 이 토큰들을 저장해 두고 등장할 때마다 불러와서 쓰고 하는 복잡한 과정들을 통해서 사용되기는 하지만 대략적인 개요는 문장을 좀 더 세분화된 형태소 또는 특정 단위로 나누어서 바라보는 것을 'Tokenization(토큰화)'라고 한다. 이 과정을 통해 나오는 출력물이 'Token(토큰)'인 것이다.

자, 토큰에 대해서 알아봤으니 이제 본격적으로 context window가 무엇인지 알아볼 시간이다! 😚 그전에 context window가 어떨 때 사용되는 것인지에 대해 먼저 알아보도록 하자. 😁 (현기증이 날 테지만 모두 꼭 필요한 정보들이니 참고 따라와 줄 수 있길 바랍니다!!) 아까 앞에서 말했던 것처럼 모델은 text를 받아들여서 토큰화를 거치고 문장의 의미를 해석하고 이렇게 해석된 문장을 가지고 출력을 해내는 역할을 한다. 그렇다면 모델이 text를 어떻게 받아들일 수 있는 것일까? 그리고 얼마큼 받아들여야 하는 걸까? 정답!! 그때 사용하는 것이 바로 이 'context window'인 것이다.

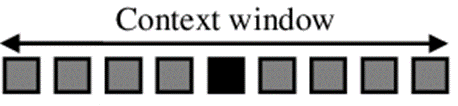

드디어 여러분이 기다리고 기다리던 정확히 context window가 무엇인지에 대해서 알아보도록 하자!! context window의 정확한 의의는 문장에서 타깃 토큰의 주변에 있는 토큰들을 의미한다. 이것을 이제 LM에서는 모델이 토큰 입력을 받아들이는 것으로 생각하면 편리하고, 이 context window의 길이는 모델이 입력으로 받아들이는 토큰의 범위라고 생각하면 된다. 예를 들어서 512개의 토큰을 context로 받아들인다고 하면 context window의 길이는 512가 되는 것이다. 더욱 자세한 내용은 다음의 포스팅에서 3-1 부분을 확인해보길 바란다. 이제 LM이 어떻게 text를 바라보는지에 대해서 알게 되었다. 바로 자세한 논문들을 살펴보기에는 아직 부족한 부분들이 있으니, 마지막으로 이제 모델이 어떻게 이 text를 이해할 수 있는지에 대해 알아보고 논문들에 대해서 살펴보겠다! 😋

Attention, how to understand the text? 🤨

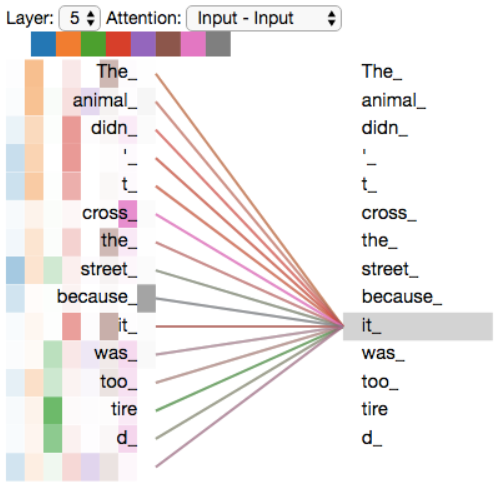

사실 모델이 text를 이해하는 방법들은 많이 있지만, 요즘의 많은 LM이 Transformer를 사용하는 만큼 Transformer에 사용된 가장 핵심 기술이자 모델이 text를 이해하는 방법 중 하나인 'Attention'에 대해서 알아보도록 하자! Attention은 그 이름에서부터 알 수 있듯이 '주의를 기울인다'라는 내용이 주가 되는 method라고 할 수 있다. 이 Attention에도 여러 가지 종류가 있는데 지금 살펴볼 것은 Transformer에서 사용된 'Self-Attention'이다.

Self-attention의 자세한 내용을 여기서 전부 다루기에는 그 양이 상당히 방대하기에 여기서는 간단히 얘기해보도록 하겠다. Attention은 입력 시퀀스 내에서 토큰 간의 관계를 학습하여 중요한 정보를 강조하는 기술로, Self-attention은 두 가지 문장을 비교하여 각 문장의 요소끼리의 관계를 파악하는데, 이때 두 가지 문장을 똑같은 문장으로 사용하는 것이다. 좀 더 자세한 내용에 대해서는 다음의 포스팅의 '4. 쉽게 이해하는 Transformer - Self-attention' 부분을 확인해보길 바란다.

Attention은 지금까지의 방식들과는 다른 방법으로 text를 바라보고 이해함으로써 혁신을 불러일으켰다. 하지만, 승승장구하던 Attention에게도 어둠이 드리웠으니.. 그건 바로 context window의 length를 늘리기가 쉽지 않다는 점이다! 😥 이는 Attention이 작동하는 방식을 보면 쉽게 알 수 있는데, Attention은 두 문장의 모든 요소를 함께 비교하게 되니 어쩔 수 없이 $O(n^{2})$의 시간 복잡도를 가지게 되어 context window length를 늘리게 되면, 계산량이 곱절로 늘어나게 되어 컴퓨팅 자원의 제약에 부딪히게 된다.. (안 돼..!! 😭😭) 그러나 이러한 Attention의 제약을 해결하고자 하는 많은 연구들이 뒤에 나오게 되었고, 다음 섹션에서는 이러한 연구들에 대해서 알아보도록 하겠다!

Let's extend the context window! 😋

context window를 늘려보기 전에!! 왜 이 context window의 길이를 늘려야 할까? 🤨 자 한 번 생각해 보자. 만약 context window의 길이가 짧으면 모델이 text를 받아들일 때 한 번에 받아들이지 못하고 하나의 text도 여러 개로 나눠서 받아들여야 하는 등의 문제가 발생하기 마련이다. 이렇게 되면 어떤 문제가 발생할까? 예를 들어 보면, 책 한 장을 넘길 때마다 이전 내용을 까먹고 새로운 내용을 보게 되는 것이라고 표현할 수 있을 것 같다. 😄 물론 비유가 이런 것이지 실제로 모델이 새로운 것을 배우면 이전 기억을 모두 까먹는다는 것이 아니다!! 🙅 결국 정리해 보면, context window의 길이가 짧아지면 문맥의 파악에 흐름이 끊기게 될 것이다. 따라서 이러한 문제를 해결하기 위해 context window를 늘리는 것이라고 생각하면 될 것 같다.

이제 이유도 알게 되었으니 context window를 어떻게 늘릴 수 있었는지에 대해서 한 번 알아보도록 하자!! 🚩 여러가지 연구들이 있었으나 모든 내용을 다루기에는 그 양이 방대하기에 예전 연구들에 대해서는 간략한 설명과 함께 리뷰 링크를 따로 달아두도록 하겠다.

- Transformer-XL(리뷰 링크: 클릭): context window를 늘린다기 보다는 고정된 context length에서 발생하는 문제를 해결하고 약해진 long-term dependency 문제 해결

- XLNet(리뷰 링크: 클릭): Transformer-XL을 좀 더 개선시키고, 양방향 학습을 함

- Sparse Transformer(리뷰 링크: 클릭): 기존의 Attention이 모든 요소를 비교하는 것에 반해 약간의 흠을 줌으로써 시간 복잡도를 $\mathbf{O}(n \sqrt{n})$으로 줄인 모델

- Longformer(리뷰 링크: 클릭): Sliding window + Dilated Sliding + Global attention을 활용하여 좀 더 sparse한 attention을 만듦으로써 더욱 긴 context length를 가능하게 한 모델

- BigBird(리뷰 링크: 클릭): Random + Sliding + Global attention을 활용하여 좀 더 sparse한 attention을 만듦으로써 더욱 긴 context length를 가능하게 한 모델

위와 같이 LM의 context length를 늘리고자 시도했던 많은 논문들이 있었다. 이 논문들의 대략적인 접근 방식을 살펴보면, 앞서 언급했던 Attention의 quadratic computation 문제를 full attention에서 벗어나 좀 더 spars 한 attention을 만듦으로써 계산량을 linear 하게 만들고자 하였다. 확실히 이러한 부분을 보면 attention의 quadratic 한 computation은 부담될 정도로 많은 양의 부하를 발생시키는 것 같긴 하다. 😅

논문들 외에 현재의 LLM들도 context window의 길이를 늘려가고 있는데 MosaicML의 MPT는 context window를 64K까지 늘리고, Anthropic의 Claude는 100K까지 늘리는 등 여러 시도들이 일어나고 있다. GPT-4의 context window length가 32K이고, 보통의 open-source LLM들이 2K인 것에 반해 엄청나게 늘어난 것이다! 😮

이렇게 해서 초기의 context window의 길이를 늘리기 위한 시도들과 최근의 LLM들의 context window length의 변화에 대해서 알아봤고, 이제 최근 연구들에 대해서 알아보도록 하자.

Extending Context Window of Large Language Models via Positional Interpolation (Chen et al., 2023)

이 논문에서는 interpolation과 extrapolation 이라는 개념을 활용하여 context window의 길이 제약을 해결하고자 하였다. 여기서 interpolation이란 범위 안에 있는 값을 예측하는 보간법을 의미하고, extrapolation이란 범위 밖에 있는 값을 예측하는 보외법을 의미한다. 이 개념을 활용하기 위해 Positional Interpolation을 소개함으로써 pre-training context window size를 넘어서는 input text를 interpolation 범위까지 줄일 수 있게 되면서 extrapolation을 interpolation으로 바꿀 수 있게 되었다! 😁 한 마디로, extrapolation 되는 토큰까지도 interpolation 할 수 있도록 position을 변경하였다고 이해하면 된다. 따라서 context window보다 긴 text가 온다고 해도 그 position 정보를 더욱 좁게 해서 interpolation 범위까지 좁힐 수만 있으면 되는 것이다! 그래서 논문에서도 실제로 2,048의 토큰을 수용할 수 있는 context window에서 32,768개의 토큰까지 참조할 수 있도록 하였다!

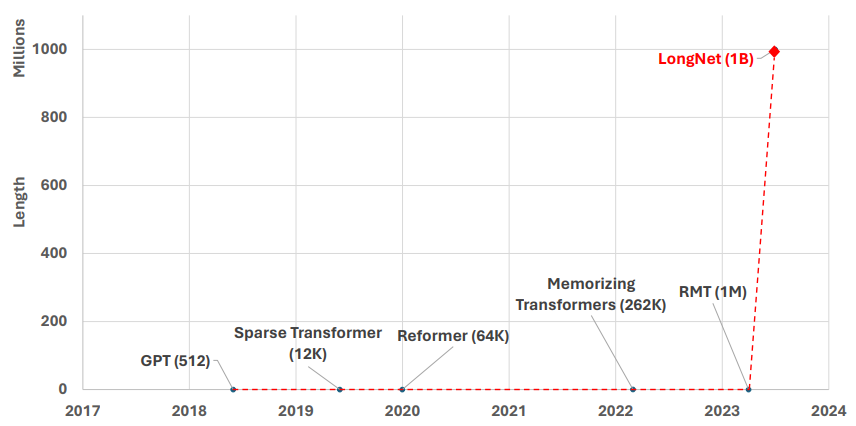

LongNet: Scaling Transformers to 1,000,000,000 Tokens (Ding et al., 2023)

Microsoft에서 발표한 이 논문은 발표하자마자 상당히 기상천외한 제목으로 사람들의 이목을 끌 수 있었다. 아니 실제로도 많이 끌었다. 누가 10억 개의 토큰을 처리할 수 있는 Transformer가 나왔다는데 구미가 당기지 않을 수가 있겠는가! 🤤 실제 논문에 있는 이전 모델들과의 context window length를 비교한 그래프를 보면 확실히 그 엄청난 위상을 확인할 수 있다.

LongNet에서는 이러한 엄청난 context window length를 기존의 attention에서 좀 더 sparse해진 'dilated attention'을 활용하고, 이 LongNet을 분산 Trainer로 사용하여 10억 개의 토큰을 받아들일 수 있어졌다. 이 dilated attention에서 segment length와 dilated rate를 변화시키면서 여러 attention을 만들고 그 attention을 합쳐서 하나의 dilated attention을 만드는 방식이다. 자세한 내용에 대해서 알고 싶다면 이 유튜브 영상를 확인하길 바란다.

이렇게 해서 만들어진 LongNet은 실제로 실험에서도 기존의 vanilla Transformer의 attention에 비해서 말도 안 될 정도로 적은 런타임으로 훨씬 더 긴 문장을 해석할 수 있음을 보여줬다! 🔥

Should the context window be longer? 😏

이렇게 해서 context window의 length를 늘리는 방법들에 대해서 알아봤다. 그리고 여러 논문들에서 context window의 length를 늘리니 성능도 더 좋게 나타나는 것으로 보였다. 하지만 실제로 모델이 추론을 할 때 이 context window로 들어온 모든 내용들을 활용하는 걸까? 만약 사실 그렇지 않다면, 이렇게 무분별하게 context window의 length를 늘리는 것은 오히려 LM에게 독이 될 수도 있다! 😮 따라서 context window의 length를 늘림에 따라 발생하는 변화를 파악하고 분석하기 위한 연구들도 필요하다. 이번 섹션에서는 Stanford University와 UC Berkeley에서 함께 작성한 논문인 'Lost in the Middle: How Language Models Use Long Contexts'(줄여서 'Lost in the Middle'이라고 부르도록 하겠다!)에 대해서 알아보고 context window의 길이에 따른 영향에 대해 알아보고자 한다.

Lost in the Middle: How Language Models Use Long Contexts (Liu et al., 2023)

'Lost in the Middle' 논문은 2023년 7월 에 나온 논문으로 앞서 설명한 'Extending Context Window...'와 LongNet의 발표 이후로 context window의 정확한 영향에 대해 평가 및 분석하기 위해 작성되었다. 이 논문에서 하는 실험들을 요약해서 설명하면 다음과 같다.

여러 문서를 입력으로 주고 그 중 하나의 문서만 정답을 포함하고 있는 질문을

던지고, 그 질문의 위치에 따른 성능 변화를 파악해 보자!

위와 같은 방식으로 모델이 정답 문서가 input text의 어떤 위치에 있을 때 가장 잘 찾아내는지를 알아낼 수 있다. 논문에서 여러 가지 실험을 진행해 보는데 대부분의 실험에서 다음의 그림과 같은 U자형 그래프를 얻는 것을 볼 수 있다. 따라서 모델은 input text의 초입과 끝 부분에 정답 문서가 있을 때 가장 성능이 좋다는 것을 확인할 수 있다.

이러한 그래프를 보면 아무리 입력이 길다고 해서(= context window length가 길다고 해서) 성능이 나아지지는 않을 뿐더러, 그 모든 정보를 활용하지 못한다라는 것을 알 수 있다. 실제로 논문에서도 마지막 분석에 너무 많은 문서를 입력으로 주는 것은 성능 개선에 별 영향을 미치지 못하고, 따라서 관련 정보를 input context의 초입에 제공해 주거나 적은 수의 문서를 사용하는 것이 더 낫다고 주장한다.

My opinion 😙

물론 'Lost in the Middle' 논문에서는 정보 추출 task에 대해서만 성능을 평가한 것이라 모든 task에 대해 이러한 경향이 있을 것이라고는 단정지을 수 없으나 정보 추출 task에서 이러한 모습을 보여준다는 것은 다른 task에서도 이런 비슷한 경향을 띌 수도 있다는 것을 보여준다. 😥 따라서 보다 확실한 검증을 위해서는 더 넓은 범위의 task에 대해서 실험을 진행하며 보다 확실한 분석을 하는 연구들이 나와줘야 한다. 모델에 새로운 method를 적용하여 새롭고 더 개선된 모델을 제안하는 것도 좋지만, 이러한 method로 인해 나온 결과에 문제는 없는지, 괜찮은 것인지 분석하는 것도 상당히 중요하다고 생각한다. 😐

이렇게 해서 LM의 context window에 대해서 알아보았는데, 필자의 의견을 잠깐 말해보자면, 필자는 아직 좀 더 많은 연구가 필요하다고 생각한다. 확실하게 context window의 length를 늘리는 것이 이점을 가진다는 것을 발견하지 않는 이상 무작정 context window를 늘려가는 것은 너무 무모한 도전이라고 생각한다. 물론 이것은 한 사람의 의견에 불과하니 너무 무겁게 듣지는 말고, 가볍게 흘려듣길 바란다! 😁 이 글을 읽은 여러분들의 의견들도 댓글에 남겨주시면 감사할 것 같습니다! 포스팅 끝까지 읽어주셔서 감사합니다! 🙇