이전에 리뷰했던 논문인 'It's Not Just Size That Metters; Small Language Models Are Also Few-Shot Learners'에서 사용된 PET에 대해 궁금해서, 이번 포스트에서는 PET을 처음으로 소개한 논문인 'Exploiting Cloze Questions for Few Shot Text Classification and Natural Language Inference'에 대해서 리뷰하였다.

It's Not Just Size That Metters; Small Language Models Are Also Few-Shot Learners 논문 리뷰: https://cartinoe5930.tistory.com/entry/Its-Not-Just-Size-That-Matters-Small-Language-Models-Are-Also-Few-Shot-Learners-%EB%85%BC%EB%AC%B8-%EB%A6%AC%EB%B7%B0

It's Not Just Size That Matters: Small Language Models Are Also Few-Shot Learners 논문 리뷰

The overview of this paper GPT-3는 획기적인 양의 데이터로 pre-train을 진행하고, 그에 상응하는 상당한 양의 파라미터를 통해 엄청난 성능 향상을 보여줬다. 하지만, 이렇게 거대한 양의 데이터를 사용

cartinoe5930.tistory.com

The overview of this paper

몇몇의 NLP task들은 비지도 방식으로 학습한 LM으로도 'task description'을 활용하여 해결이 가능하다. 하지만 이런 방식은 지도 학습에 비해 떨어지는 성능을 보여주지만, 두 개의 아이디어를 합칠 수 있다는 것을 보여줬다. 논문에서는 준지도 학습으로 input example을 cloze-style 구문으로 변환해서 LM이 주어진 task에 대해 잘 이해할 수 있도록 도와주는 Pattern Exploiting Training$($PET$)$을 소개하였다. 이러한 구문은 unlabeled example에 대해 soft label을 지정해줄 수 있었다. 마지막으로, 결과로 나온 학습 데이터셋에 대해 기존의 지도 학습이 사용될 수 있다. 다양한 task와 언어에 대해 PET은 적은 자원의 환경에서 지도 학습과 강력한 준지도 학습 방식을 크게 능가하는 모습을 보여줬다.

Table of Contents

1. Introduction

2. Pattern Exploiting Training

2-1. PVP Training and Inference

2-2. Auxiliary Language Modeling

2-3. Combining PVPs

2-4. Iterative PET $($iPET$)$

3. Analysis

1. Introduction

example로부터 학습하는 것이 많은 NLP task들에 대해 우세한 방법이다. 세상에는 수많은 언어와 다양한 분야와 task들이 있고, 데이터를 라벨링하는데 많은 비용이 들기 때문에, 실제로 NLP를 진행할 때 적은 수의 labeled example을 사용하는 것이 보통이다. 이러한 연구 환경이 few-shot learning의 주요성을 대두시켰다. 불행하게도, 적은 양의 학습 데이터에 대해 지도 학습을 진행하는 것은 종종 안 좋은 성능을 보여준다. 여러 가지 문제들은 적은 example을 보고 이해하는 것이 힘들다는 것이다. 예를 들어, 다음의 3개의 문장을 받았다고 가정해보자.

- $T_1$: This was the best pizza I've ever had.

- $T_2$: You can get better sushi for half the price.

- $T_3$: Pizza was average. Not worth the price.

여기에서, 모델에게 $T_1$과 $T_2$의 라벨이 $l$과 $l'$ 각각이라고 말해주고, $T_3$의 알맞은 라벨을 추론해서 대답하게 하도록 상상해보자. 오직 이 example에 대해서는, $l$과 $l'$에 대해서 둘 다 그럴 듯한 타당한 이유를 찾을 수 없기 때문이다. 그러나 기본 task가 텍스트가 price에 대해 말하는지 여부를 식별하는 것임을 안다면 그 쉽게 $l'$을 $T_3$로 지정할 수 있다. 이것은 task description이 있을 때, 적은 example로도 쉽게 task를 해결할 수 있다는 것을 설명해준다. 예를 들어, 원문적 설명은 task가 어떤 것인지에 대한 이해를 도와준다.

pre-trained model의 발전데 따라서, task description을 제공해준다는 아이디어는 신경망 architecture에 적용 가능해졌다. task description을 입력에 사용할 자연어에 추가하는 것으로 PLM이 task를 해결할 수 있도록 도와준다. 이 방식에서 학습 데이터가 아예 없다면 zero-shot scenario가 되는 것이다.

논문에서는 task description 제공이 기존의 few-shot 세팅과 통합될 수 있다는 것을 보여줬다. 논문에서는 준지도 학습 방식으로 자연어 패턴을 이용하여 input example을 cloze-style 구문으로 변환하는, Pattern-Exploiting Training$($PET$)$를 소개하였다. 그림 1에서 소개되어 있는 것처럼, PET은 다음의 세 단계로 작동한다.

- 각각의 패턴에 대해 분리된 PLM은 작은 학습 데이터셋 $\tau$으로 fine-tune된다.

- 모든 모델의 ensemble은 커다란 unlabeled dataset D를 soft label로 라벨링한다.

- 기존의 분류기는 soft-labeled dataset에 대해 학습한다.

PET뿐만 아니라 iPET도 소개하였는데, iPET은 PET의 반복$($iterative$)$ 버전으로, 이러한 프로세스는 학습 데이터셋의 크기를 증가시키면서 반복된다.

다양한 언어에 대한 다양한 task에서, 작거나 중간 정도 수의 labeled example로 PET과 iPET이 비지도 학습, 지도 학습과 강력한 준지도 학습 방식을 능가하는 모습을 보여준다는 것을 밝혀냈다.

2. Pattern-Exploiting Training

$M$은 vocabulary $V$와 mask token ___$ \in V$을 포함하고 있는 MLM이고, $\mathfrak{L}$은 target classification task에 대한 label set이다. task A에 대한 입력으로 구문의 sequence인 $\textbf{x} = (s_1, ..., s_k)$와 $s_i \in V^{*}$이다. 예를 들어, A가 텍스트 추론인 경우 $k=2$이다. 논문에서는 pattern이 $\textbf{x}$를 입력으로 받아서 정확하게 하나의 mask token을 갖는 구문 또는 문장 $P(\textbf{x}) \in V^{*}$를 출력하는 함수 P가 되도록 정의하였다. 그리고 verbalizer을 각각의 label을 M의 vocabulary로부터 단어를 매핑하는 injective function $v: \mathfrak{L} \to V$을 정의하였다. 이러한 $(P, v)$를 pattern-verbalizer pair$($PVP$)$을 부르기로 하였다.

PVP $(P, v)$을 사용하면 task A를 다음과 같이 해결할 수 있다. input $\textbf{x}$가 주어지면, input representation $P(\textbf{x})$을 얻기 위해 $P$를 적용하였다. 그 다음에 $P(\textbf{x})$는 $M$에 의해 처리되어 $v(y)$가 마스크를 대체할 가능성이 가장 높은 레이블 $y \in \mathfrak{L}$을 결정한다. 예를 들어, 두 문장 $a$와 $b$가 반대되는 문장이면 라벨을 $(y_0)$로, 두 문장이 같은 의미이면 라벨을 $(y_1)$으로 지정하는 task라고 생각해보자. 이 task에 대해 패턴 $P(a, b) = $ a? ___ b. 으로 만들고, $y_0$을 'Yes', $y_1$을 'No'로 매핑하는 verbalizer $v$와 합쳤다. 다음과 같은 예시 입력 짝이 주어졌다고 해보자.

$\textbf{x} = $(Mia likes pie, Mia hates pie)

이제 task는 두 문장의 사이에 'No' 또는 'Yes' 둘 중 무엇이 더 잘 어울리는지 파악하는 task로 바뀌었다.

$P(\textbf{x}) = $ Mia likes pie? ____, Mia hates pie.

2-1. PVP Training and Inference

$\textbf{p} = (P, v)$가 PVP라고 하자. 작은 학습셋 $T$와 unlabeled example $D$에 접근할 수 있다고 가정해보자. 정확히 하나의 mask token과 $w \in V$를 포함하는 각각의 sequence $\textbf{z} \in V^{*}$에 대해, LM이 masked position에서 $w$에 할당하는 비정규화 점수를 $M(w | z)$로 표시한다. 입력 $\textbf{x}$가 주어지면, label $l \in \mathfrak{L}$에 대한 점수를 다음과 같이 정의한다.

그리고 이 라벨에 대해 softmax를 사용해서 당므과 같은 확률 분포를 얻을 수 있다.

$q_{\textbf{p}}(l | x)$와 training example $(x, l)$의 사실$($one-hot$)$ 분포 간에 cross-entropy를 사용해서 $\textbf{p}$를 위한 M의 fine-tuning에 대한 loss를 제공한다.

2-2. Auxiliary Language Modeling

논문의 응용 시나리오에서, 오직 적은 양의 training example만이 사용 가능했고, catastrophic forgetting이 일어날 수 있었다. 일부 PVP용으로 fine-tuning된 PLM은 여전히 핵심 LM이므로 language modeling을 보조 작업으로 사용하여 이 문제를 해결한다. 최종 loss는 다음의 수식처럼 계산된다. $L_{CE}$는 cross-entropy loss를 의미하고, $L_{MLM}$은 language modeling loss를 의미한다.

$L_{MLM}$이 $L_{CE}$보다 크고, 이전의 실험에서 $\alpha = 10^{-4}$이 일관되게 좋은 결과를 준다는 것을 알아냈기 때문에, 이를 모든 실험에 사용하였다. language modeling을 위한 문장을 얻기 위해, unlabeled dataset $D$를 사용하였다. 하지만, 각각의 $\textbf{x} \in D$에 대해 바로 학습시키는 대신에 $P(\textbf{x})$에 대해 학습시켰다. 여기서 LM에게 masked slot에 대해 예측하도록 질문하지 않았다.

2-3. Combining PVPs

논문의 방식은 large development set이 부재해서, 어떤 PVP가 잘 작동하는지 확인하지 못하는 어려움이 있었다. 이를 해결하기 위해, knowledge distillation과 유사한 방법을 사용하였다. 첫 번째로, task A를 만족하는 PVP의 set $P$를 정의하였다. 그리고 이 PVP를 다음과 같이 사용하였다.

(1) 분리된 각각의 $\textbf{p} \in P$에 대해서 LM $M_{\textbf{p}}$를 fine-tune 하였다. $T$이 작은 것처럼, fine-tuning은 PVP의 수가 많다고 해도 비용이 그리 비싸지 않다.

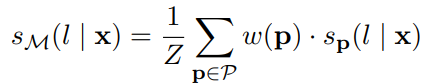

(2) unlabeled dataset $D$에서 나온 example을 라벨링하기 위해서 fine-tuned model의 ensembel $\mathfrak{M}={M_{\textbf{p}} | \textbf{p} \in P}$을 사용하였다. 각각의 example $\textbf{x} \in D$에 대한 정규화되지 않은 클래스 점수를 다음과 같이 합쳤다.

여기서 $Z = \sum_{\textbf{p} \in P} w(\textbf{p})$이고, $w(\textbf{p})$는 PVP를 위한 weighting term이다. 논문에서는 두 개의 서로 다른 weighting term에 대해 실험을 진행하였다. 모든 $\textbf{p}$에 대해 $w(\textbf{p})=1$로 설정하거나 학습을 하기 전에 $\textbf{p}$를 사용해서 얻어진 정확도를 $w(\textbf{p})$로 설정하였다. 이 두 개의 변수를 각각 uniform과 weighted로 부르기로 하였다.

위의 점수를 softmax를 사용해서 확률 분포 $q$로 변환하였다. 논문에서는 temperature $T = 2$로 설정해서 적합한 soft 분포를 얻었다. 모든 $(\textbf{x}, q)$는 training set $\tau_{C}$로부터 얻어졌다.

(3) $\tau_{C}$에서 표준 시퀀스 분류 헤드로 PLM $C$를 fine-tuning해야 한다.

이렇게 fine-tuned model $C$는 task A에 분류기로 여겨진다. 위의 단계들은 다음의 그림 2에 모두 나타나 있다. 그림 2에서 iPET의 부분을 제외한 1, 2, 3이 PET의 작동 방식이다.

2-4. Iterative PET $($iPET$)$

모든 모델의 지식을 분해하는 것은 서로끼리 학습할 수 없음을 의미한다. 어떤 패턴은 다른 것보다 잘 작동하지 않는 것처럼 final model의 training set $\tau_{C}$는 mislabeled data를 많이 함유하고 있다.

이러하 단점을 극복하기 위해, PET을 반복해서 하는 iPET을 고안하였다. iPET의 핵심 아이디어는 증가해가는 크기의 데이터셋에서 여러 개의 generation을 학습시키는 것이다. 이를 이루기 위해, 기존의 데이터셋 $\tau$를 $D$로부터 선택된 라벨링 example에 학습된 PET model의 랜덤 서브셋을 사용해서 확대시켰다$($그림 2a$)$. 그 다음에 확대된 데이터셋 $($b$)$에서 PET model의 새로운 generation을 학습시켰다$($그림 2b$)$. 그리고 이 프로세스를 여러번 반복한다$($그림 2c$)$.

3. Analysis

Combining PVPs

논문에서는 먼저 일부 PVP가 다른 PVP보다 성능이 훨씬 떨어지는 상황에 PET가 대처할 수 있는지 조사하였다. $|\tau| = 10$에 대해, 표 1은 PET의 성능을 fine-tuning 후에 best와 worst 성능과 비교하였다. 그리고 논문에서는 knowledge distillation 없이 개별 PVP에 해당하는 PET 모델의 ensemble을 사용하여 얻은 결과도 포함하였다. fine-tuning후에도, Yelp에서는 best와 worst의 성능 갭 차이가 컸다. 하지만, PET은 이를 해결할 수 있을 뿐만 아니라, 모든 task에서 가장 성능이 좋은 패턴만 사용하는 것보다 정확도가 향상되었다. Distillation은 ensemble에 대해 일관적인 향상을 가져왔고, 추가적으로, 최종 분류기의 크기를 줄여주었다. 그치만 PET의 uniform과 weighted 사이는 유의미한 차이를 발견하지 못했다.

Auxiliary Language Modeling

논문에서는 PET의 성능에 대한 auxiliary language modeling task의 영향을 분석하였다. 그림 3은 네 개의 training set 크기에 language modeling task를 추가할 때 성능 향상을 보여줬다. 그리고 10개의 example에 대해서 학습할 때 auxiliary task가 가장 효과적이라는 것을 알아냈다. 더 많은 데이터에 대해서는, auxiliary language modeling의 중요성이 줄어들었고, 때로는 성능 악화로 이끌기도 했다. 오직 MNLI에 대해서는 일관되게 도움 된다는 것을 알았다.

Iterative PET

더 많은 generation을 하는 iPET이 진짜로 성능을 향상시키는지 확인하기 위해, 다음의 그림 4에서 zero-shot 세팅에서 model의 모든 generation의 평균 성능을 보여주고 있다. 각각의 추가적인 반복은 emsemble의 성능을 실제로 향상시키고 있었다.

이제 자연스럽게 질문이 하나 생길 것이다. 만약 training set의 크기가 커지고 더 적은 반복을 하게 되면 비슷한 결과를 얻을 수 있게 될까? 이 질문에 대답하기 위해, generation 2와 3을 skip하고 바로 $\mathfrak{M}_1$에서 $\mathfrak{M}_4$으로 넘어갔다. 그림 4에 나와있는 점선을 보면 이것이 확연하게 성능 저하로 이어지며 학습셋의 크기를 점진적으로 늘리는 거의 중요성을 강조하였다. 논문에서는 이것이 많은 example을 너무 빨리 labeling하면 mislabeled training example의 비율이 올라가기 때문이라고 추측하였다.

In-Domain Pretraining

논문의 지도 학습 baseline들과 달리 PET은 추가적인 unlabeled dataset $D$의 사용하였다. 따라서, PET의 성능 향상의 최소한의 부분은 지도학습 baseline에 대한 PET의 성능 향상은 추가적 in-domain data에서부터 나온 것이다.

이 가설을 증명하기 위해, 논문에서는 RoBERTa를 text classification 정확도를 향상시키는 전형적인 방법 중 하나인 in-domain data에서 추가적으로 pre-train 하였다. 다음의 그림 5는 지도 학습 방식과 PET에 대해 in-domain training이 있을 때와 없을 때의 성능을 보여주고 있다. pre-training이 실제로 지도 학습 방식의 정확도를 향상시키기는 하지만, 지도 학습 모델은 아직 확실히 PET에 못 미치는 성능을 보여줬다. 이것은 PET이 단순히 추가적인 unlabeled data의 사용으로 인해 성공한 것이 아니라는 것을 증명해주고 있다. 흥미롭게도, PET은 in-domain training은 PET에게도 도움이 되었다! 이는 PET가 표준 마스킹된 LM pre-training과 분명히 다른 방식으로 unlabeled data를 활용함을 나타낸다.

출처

https://aclanthology.org/2021.eacl-main.20.pdf